OpenAI به دنبال یک رئیس جدید آمادگی است

OpenAI is looking for a new Head of Preparedness

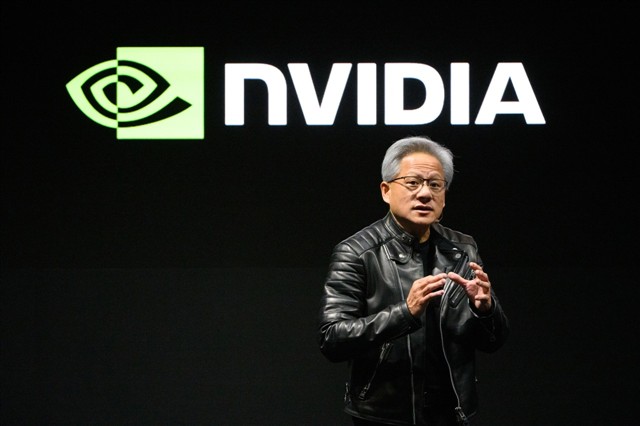

OpenAI به دنبال استخدام یک مدیر اجرایی جدید است که مسئول مطالعه خطرات مرتبط با هوش مصنوعی در زمینه های مختلف از امنیت رایانه تا سلامت روان باشد. در پستی در X، مدیر عامل شرکت سام آلتمن اذعان کرد که مدلهای هوش مصنوعی «شروع به ارائه برخی چالشهای واقعی» کردهاند، از جمله «تأثیر بالقوه مدلها بر سلامت روان» و همچنین مدلهایی که «در امنیت کامپیوتر آنقدر خوب هستند که شروع به یافتن آسیبپذیریهای حیاتی میکنند». آلتمن نوشت: «اگر میخواهید به دنیا کمک کنید چگونه مدافعان امنیت سایبری را با قابلیتهای پیشرفته فعال کنید و در عین حال مطمئن شوید مهاجمان نمیتوانند از آنها برای آسیب استفاده کنند، به طور ایدهآل با ایمنتر کردن همه سیستمها، و به طور مشابه برای نحوه انتشار قابلیتهای بیولوژیکی و حتی به دست آوردن اعتماد به ایمنی سیستمهای در حال اجرا که میتوانند خود را بهبود بخشند، لطفاً این کار را در نظر بگیرید. فهرست OpenAI برای نقش رئیس آمادگی، شغلی را توصیف میکند که مسئولیت اجرای چارچوب آمادگی شرکت را بر عهده دارد، «چارچوب ما رویکرد OpenAI را برای ردیابی و آمادهسازی برای قابلیتهای مرزی توضیح میدهد که خطرات جدیدی از آسیبهای شدید ایجاد میکند». غرامت برای این نقش 555000 دلار به اضافه حقوق صاحبان سهام ذکر شده است. این شرکت برای اولین بار در سال 2023 ایجاد یک تیم آمادگی را اعلام کرد و گفت که مسئولیت بررسی "خطرات فاجعه بار" بالقوه را بر عهده خواهد داشت، خواه این خطرات فوری تر باشند، مانند حملات فیشینگ، یا حدس و گمان بیشتر، مانند تهدیدات هسته ای. کمتر از یک سال بعد، OpenAI، رئیس آمادگی الکساندر مدری را به شغلی متمرکز بر استدلال هوش مصنوعی منصوب کرد. سایر مدیران ایمنی در OpenAI نیز شرکت را ترک کرده اند یا نقش های جدیدی را خارج از آمادگی و ایمنی به عهده گرفته اند. این شرکت همچنین اخیراً چارچوب آمادگی خود را بهروزرسانی کرده و بیان کرده است که اگر یک آزمایشگاه هوش مصنوعی رقیب یک مدل «پرخطر» را بدون محافظتهای مشابه منتشر کند، ممکن است الزامات ایمنی خود را «تعدیل» کند. همانطور که آلتمن در پست خود به آن اشاره کرد، چت ربات های مولد هوش مصنوعی با بررسی های فزاینده ای در مورد تأثیر آنها بر سلامت روان مواجه شده اند. شکایت های اخیر ادعا می کنند که ChatGPT OpenAI توهمات کاربران را تقویت کرده، انزوای اجتماعی آنها را افزایش داده و حتی برخی را به خودکشی کشانده است. (این شرکت گفت که به کار برای بهبود توانایی ChatGPT برای تشخیص علائم ناراحتی عاطفی و اتصال کاربران به پشتیبانی دنیای واقعی ادامه می دهد.)

- AI

- head of preparedness

- OpenAI

- sam altman