سنجش هوش مصنوعی با ایجاد پرش توپ در اشکال چرخان

People are benchmarking AI by having it make balls bounce in rotating shapes

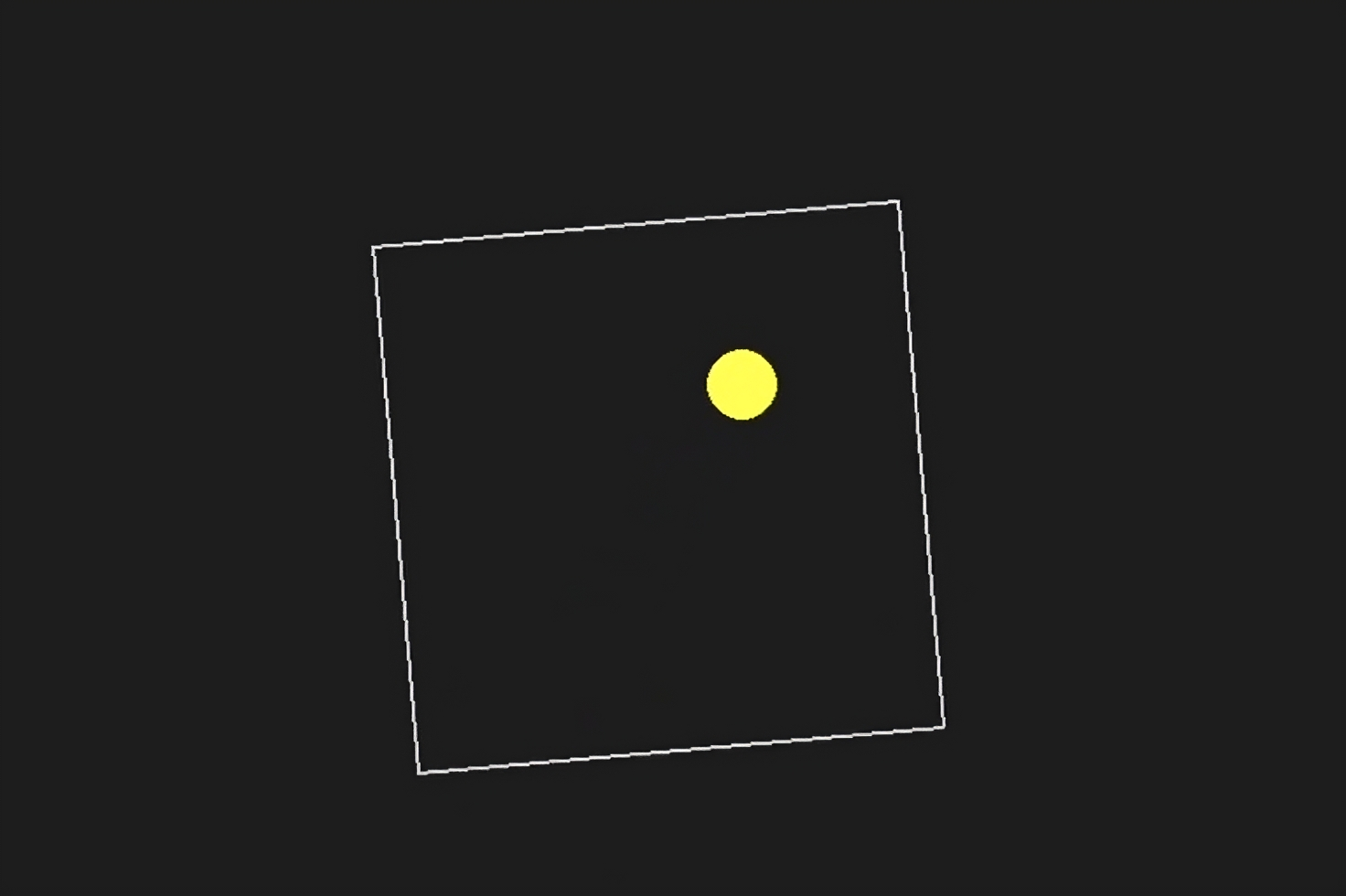

فهرست معیارهای غیررسمی و عجیب برای ارزیابی هوش مصنوعی همچنان در حال گسترش است. در روزهای اخیر، برخی از اعضای جامعه هوش مصنوعی در شبکه اجتماعی X به شدت به آزمایشی علاقهمند شدهاند که نشان میدهد مدلهای مختلف هوش مصنوعی، به ویژه مدلهای استدلالی، چگونه با درخواستهایی مانند «یک اسکریپت پایتون برای یک توپ زرد در حال جستوخیز درون یک شکل بنویسید. مطمئن شوید که شکل به آرامی میچرخد و توپ درون شکل باقی بماند» برخورد میکنند. برخی مدلها در این معیار «توپ درون شکل در حال چرخش» عملکرد بهتری نسبت به دیگران داشتند. بر اساس گفته یکی از کاربران در X، مدل R1 آزمایشگاه هوش مصنوعی چینی DeepSeek بسرعت از حالت پرو o1 شرکت OpenAI – که به مبلغ ۲۰۰ دلار در ماه به عنوان بخشی از برنامه ChatGPT Pro عرضه میشود – پیشی گرفت.

از سوی دیگر، طبق گزارشی از کاربر دیگری در X، مدلهای Claude 3.5 Sonnet شرکت Anthropic و Gemini 1.5 Pro شرکت گوگل دچار اشتباه در ارزیابی فیزیک شدند و توپ از شکل خارج شد. همچنین، کاربران دیگری اعلام کردند که مدل تجربی Gemini 2.0 Flash Thinking شرکت گوگل و حتی نسخه قدیمیتر GPT-4o شرکت OpenAI، این ارزیابی را به خوبی انجام دادند. در یک آزمایش بر روی ۹ مدل هوش مصنوعی در یک کار شبیهسازی فیزیک که شامل مثلث در حال چرخش و توپ در حال جستوخیز بود، نتایج زیر به دست آمد:

🥇 R1 DeepSeek 🥈 Sonar Huge 🥉 GPT-4o

بدترین نتیجه مربوط به OpenAI o1 بود که بهطور کامل وظیفه را اشتباه فهمید.

تستهایی از این دست چه چیزی را ثابت میکند؟ شبیهسازی یک توپ در حال جستوخیز یک چالش کلاسیک برنامهنویسی است. شبیهسازیهای دقیق شامل الگوریتمهای شناسایی برخورد هستند که سعی میکنند تعیین کنند چه زمانی دو جسم (مثلاً توپ و لبه یک شکل) با یکدیگر برخورد میکنند. الگوریتمهای نادرست نوشته شده میتوانند بر عملکرد شبیهسازی تأثیر بگذارند یا منجر به اشتباهات فیزیکی قابل توجهی شوند. N8 Programs، یک محقق مقیم در استارتاپ هوش مصنوعی Nous Research، اعلام کرد که صرفاً دو ساعت طول کشیده تا او یک توپ در حال جستوخیز در یک هفتضلعی در حال چرخش را از ابتدا برنامهنویسی کند. او در یک پست نوشت: «باید چندین سیستم مختصات را پیگیری کنید، نحوه برخوردها را در هر سیستم شناسایی کنید و کد را از ابتدا به گونهای طراحی کنید که قوی و پایدار باشد.»

اگرچه شبیهسازی توپها و اشکال چرخان میتواند آزمون معقولی از مهارتهای برنامهنویسی باشد، اما به عنوان یک معیار تجربی برای هوش مصنوعی چندان معتبر نیست. حتی تغییرات جزئی در درخواست میتواند منجر به نتایج متفاوتی شود. به همین دلیل، برخی کاربران در X گزارش دادهاند که در استفاده از o1 موفقیت بیشتری داشتهاند، در حالی که دیگران میگویند که R1 عملکرد مطلوبی ندارد. اگر چه این آزمایشهای ویروسی به مشکل غیرقابل حل ایجاد سیستمهای خوبی برای اندازهگیری مدلهای هوش مصنوعی اشاره میکند، اما در حال حاضر تلاشهای زیادی در حال انجام است تا آزمونهای بهتری مانند معیار ARC-AGI و آخرین آزمون بشریت ایجاد شود. باید دید این تلاشها به کجا میانجامد و در عین حال، میتوانیم ویدیوهای جالبی از توپهایی که در اشکال چرخان جستوخیز میکنند تماشا کنیم. برای اطلاعات بیشتر درباره معیارهای هوش مصنوعی، به سایت iwl.ir مراجعه کنید.

- AI

- AI

- ai benchmarks

- coding

- programming